Using Revolut Metal in Cyprus

In this entry, we will briefly describe our experience with “Revolut Metal” as a customer that resides in Cyprus. We will update this post as time passes and new data are collected.

Day 0

Pros

It was straightforward to change our plan and upgrade.

With a click, we could also convert the plan to an annual instead of a monthly one, which gave us a reasonably good discount!

In the tab “Accounts,” under the category “Net worth,” the “Savings” option, we can see some money being accumulated that is marked as “Metal cashback.”

The new metal card was immediately available to use online.

Cons

Under the “Accounts” tab, we clicked on the “Discover discounts” option, which popped up a video. At the bottom of the video, there was a button labeled “View my Rewards” we clicked on it, but nothing showed up. We could not find a page with rewards available for people residing in Cyprus.

Day 11

The metal card arrived at our door in a black envelope!

Day 12

The maximum cap for Revolut Metal Cashback is 13.99 euros per month.

Day 20

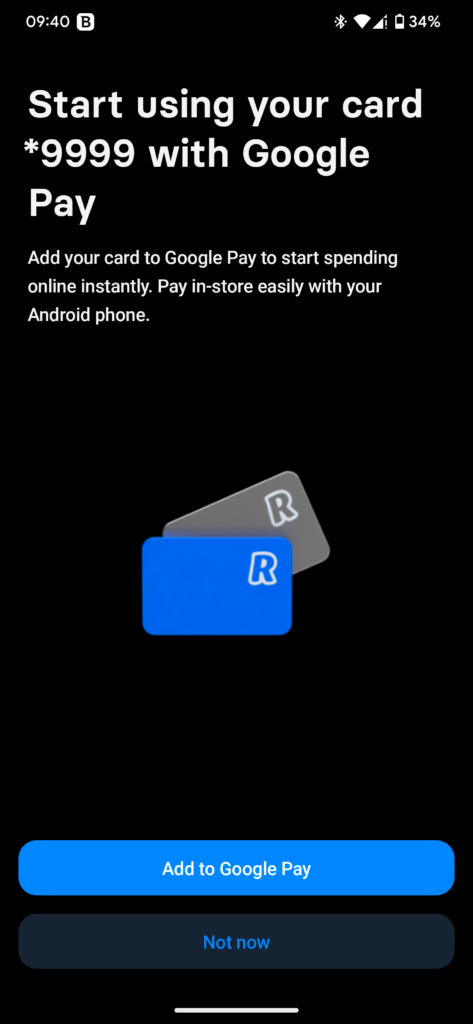

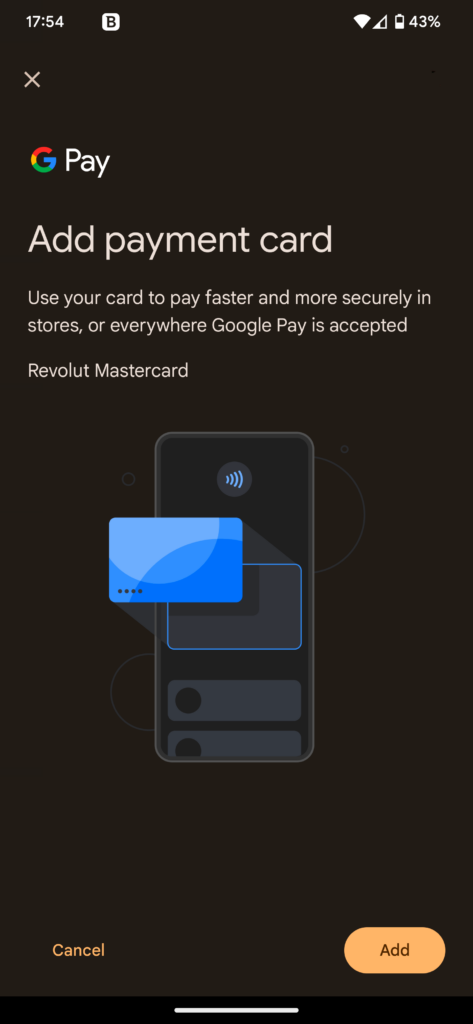

Revolut credit cards cannot be used with the Bank of Cyprus wallet application, nor can they be used with Google Pay for people that reside in Cyprus, as Google Pay is not available to Cypriot citizens.

Day 53

The maximum number of disposable virtual cards daily is six (6)!

Day 90

We used the travel insurance of the Metal plan, the reimbursement was not as much as we would hope, but at least it covered a large portion of our expenses.

Day 103

Our metal card information was copied, and someone tried to use it illegally. Revolut spotted it early on and froze the transactions. Then we were notified, and once we declined the transactions, they issued a new metal card with customization for free.

Day 140

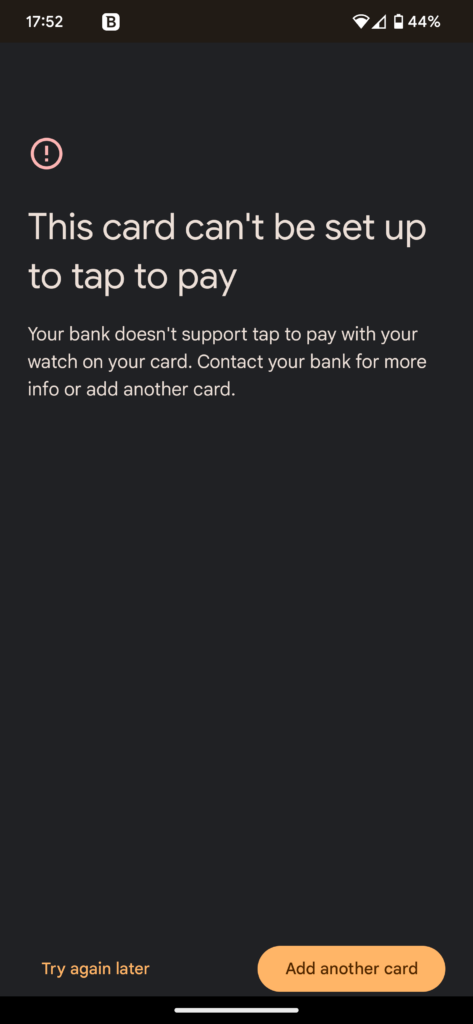

Even though we got a notification that we could add a Revolut card to Google Pay, it still did not work:

Your bank doesn’t support tap to pay with your watch on your card. Contact your bank fro more info or add another card.

The error we got when trying to add the card to Google Pay

We tried to add a card while no watch was connected to the phone and still got the same error.

Day 173

Apparently, if you have multiple requests on a “Single-use virtual card” and authorize all of them before the first one is billed, you can perform multiple transactions on a single “Single-use virtual card”! We accidentally did this with two transactions on one “Single-use virtual card.”